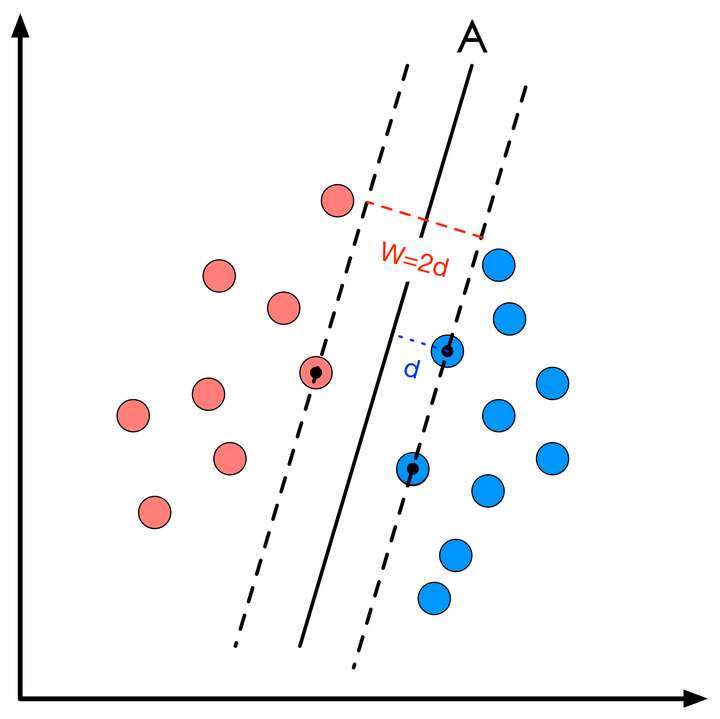

二维数据SVM模拟过程

SVM 算法的基本原理。

SVM 问题描述

对于线性可分数据,二维数据决策面方程即为一元一次方程,如下:

其用向量表示可以表示为:

点到直线距离方程为:

即在所有的点 $x$ 中,使得 $d$ 最大的直线即为决策面。

对每一个样本加上一个标签 $y_i$:

如果决策面能够完全正确的对样本进行分类,则满足:

如果决策面正好在间隔区间的中轴线上,且支持向量到决策面的距离为 $d$,那么有:

此时,令$\omega=\omega_d,\gamma=\gamma_d$,则 SVM 的优化问题的约束条件为:

线性 SVM 优化问题基本描述

决策面的方程如 (2) 所示,所有样本点到决策面的距离为:

当 $x_i$ 为支持向量时,等号成立。

式 (8) 的含义为,支持向量样本点到决策面的距离为 $\frac{1}{||\omega||}$ , 需要找到一组参数 $\omega ,\gamma$ 使得 $d$ 最小。对式 (7) 可统一表达如下:

至此,SVM 线性最优化问题的数学描述为:

学习自 零基础学SVM